ANALYSE DES PROPOSITIONS DE REGLEMENTS DSA ET DMA

Le DSA vise à règlementer la manière dont les fournisseurs de services intermédiaires en ligne interagissent avec leurs clients et leurs utilisateurs. Il s’attache aux obligations en matière de contenus illicites ou illégaux afin de créer un environnement fiable et harmonisé en ligne.

Le DMA impose aux plates-formes numériques une longue liste d’obligations afin de règlementer des pratiques considérées comme étant une entrave à la concurrence ou déloyales.

Ces deux textes législatifs créeraient le régime le plus contraignant voire interventionniste que l’Europe ait connu au cours de ces dernières décennies.

DSA

Le DSA était le plus attendu dans la mesure où il réouvrait la Directive e-commerce de 2000, jugée obsolète. Ce texte présente une liste d’obligations et d’interdictions assorties de sanctions qui devraient mettre fin aux dérives des « géants du numérique » accusés d’abuser de leur pouvoir.

Le texte est cependant bien moins ambitieux que ce que sa communication a tenté de le faire croire et les solutions proposées sont essentiellement des reprises d’un ensemble de principes que les Gafas eux-mêmes se disaient prêts à appliquer déjà depuis quelques temps, mais il faut lui reconnaître un grand nombre d’avancées très positives qui vont dans le bon sens.

Le DSA comporte 4 niveaux d’obligations :

– Le 1er niveau s’appliquerait à tous les fournisseurs de services numériques qui mettent les consommateurs européens en contact avec des biens, des services ou des contenus. Ce sont les « services intermédiaires ». Cela inclut les fournisseurs situés ou établis hors de l’Europe qui ont un nombre important d’utilisateurs européens ou qui ciblent des activités vers un ou plusieurs Etats Membres de l’UE.

- Ils seraient tous obligés d’avoir un point de contact dans l’UE ou s’ils n’ont pas d’établissement dans l’Union, ils devraient avoir un représentant de services numériques que chaque Etat Membre aura désigné comme leur principal responsable national en application du. DSA (articles 10 à 12)

- Les fournisseurs auraient obligation de fournir des informations claires dans leurs conditions générales sur toute restriction de service qui s’applique au contenu de leurs clients y compris des informations sur les outils et les politiques de modération de contenu (article 13)

- Ils devraient publier des rapports détaillés au moins une fois par an concernant leurs activités de modération de contenus.

– Le 2e niveau s’applique à un type spécifique de fournisseur de « services intermédiaires » (les fournisseurs de services d’hébergement qui stockent les informations fournies par leurs clients (stockage dans le nuage).

- Ces derniers auraient l’obligation supplémentaire de mettre en œuvre des mécanismes permettant aux tiers de leur notifier des contenus illicites et de donner suite à ces notifications en temps utile avec diligence et efficacité. La priorité étant accordée aux notifications faites par des « signataires de confiance » désignés par les autorités nationales.

- Lorsqu’ils restreignent l’accès au contenu d’un client, les fournisseurs de services d’hébergement devraient fournir au client un exposé des motifs contenant certaines informations pour aider leurs clients à comprendre les raisons de la décision et la manière dont elle a été prise.

– Le 3 e niveau s’applique spécifiquement aux plateformes en ligne, et les fournisseurs de services qui diffusent les informations de leurs clients au public (plateformes de réservation en ligne)

- Elles seraient tenues de donner à leurs clients l’accès à des mécanismes de résolution des litiges relatifs aux décisions de restreindre l’accès à leurs informations, ou de suspendre ou de résilier leur service ou leur compte.

- Elles devraient prévoir un système de traitement des plaintes et de règlement extrajudiciaire des litiges (article 17)

- Elles seraient tenues de suspendre leurs services aux clients qui fournissent fréquemment des contenus manifestement illégaux et d’alerter rapidement les autorités policières ou judiciaires si elles ont des informations qui leur permettent de soupçonner une infraction pénale grave impliquant une menace pour la vie ou la sécurité de toute personne.

- Elles auraient enfin des exigences supplémentaires en matière de notification concernant des informations sur les suspensions imposées, les règlements extrajudiciaires des litiges, l’utilisation d’outils de modération automatique du contenu et le nombre d’utilisateurs actifs moyens par mois (articles 8 et 9)

- Les plateformes d’entreprise à consommateurs (B2C) seraient tenues de prendre certaines mesures pour vérifier l’identité et la traçabilité des commerçants qui utilisent la plateforme. Les plateformes en ligne qui affichent de la publicité devraient veiller à afficher le caractère publicitaire du contenu et les critères utilisés pour le ciblage des utilisateurs (art 24)

– Le 4 e niveau s’applique aux « très grandes plateformes en ligne » c’est-à-dire celle qui sont définies comme des plateformes en ligne comptant en moyenne 45 millions d’utilisateurs actifs par mois ou plus dans l’UE (par exemple Google, Facebook, Amazon etc).

- En plus de toutes les autres obligations elles seraient tenues de faire tous les 6 mois un rapport détaillé sur la modération de contenus que la plateforme aura engagée au cours de la période concernée et un rapport annuel de transparence concernant leur politique de retrait des contenus illicites.

- Elles devraient aussi être transparentes sur la façon d’utiliser les données privées

- Enfin elles devraient notifier à la Commission tout projet d’acquisition de tout autre service numérique en Europe avant de conclure leurs opérations. Cette obligation donnerait à la Commission des possibilités de surveiller et de contrôler les fusions et acquisitions des « grandes plateformes ».

La nouveauté est que si l’exonération de responsabilité pour les intermédiaire numériques est maintenue, ce serait à condition de respecter certaines obligations :

notamment une plateforme pourrait perdre son « immunité » si elle a connaissance d’un contenu illégal sur sa plateforme mais n’agit pas avec diligence pour supprimer ce contenu. La proposition prévoit également des sanctions en cas d’infraction, mais uniquement pour les « très grandes plateformes ». Les Etats membres pourront imposer des sanctions allant jusqu’à 6% du chiffre d’affaires ou des revenus de l’année précédente, et jusqu’à 1% lorsqu’ils fournissent des informations incorrectes, incomplètes ou trompeuses. Ils pourront également infliger des astreintes allant jusqu’à 5% du chiffre d’affaires quotidien moyen.

En dernier recours le représentant légal national pourrait demander à la justice d’ordonner le blocage du service ou alors de l’intermédiaire par lequel il passe. En revanche, il faut noter que les avancées sont très limitées en matière de responsabilité des intermédiaires en ligne (art 6-7) et de lutte contre les contenu illicites (art 71) et il faut noter que l’on ne parle pas du tout des contenu préjudiciables.

La définition des contenus illicites serait par ailleurs laissée à l’appréciation des législateurs nationaux, ce qui pose un problème dans la mesure où un règlement ne se transpose pas mais s’applique en l’état, précisément pour en améliore l’harmonisation. Laisser cette décision aux Etats membres au motif que la notion « d’illicite » est différente selon les Etats membres serait une des faiblesses du texte… que ne manqueraient pas d’exploiter les plateformes.

La proposition ne prévoit aucune obligation de mettre en œuvre des mesures de « notice and takedown » à l’art 7 (l’ayant droit notifie et la plateforme retire.) Le texte reprend donc les dispositions de la directive e-commerce en ce qui concerne tous les contenus illicites des plateformes sans distinguer les hébergeurs desdites plateformes. Cette distinction aurait permis de leur appliquer des régimes différents. Même les opposants à la responsabilité des plateformes auraient souhaité qu’il soit envisagé une responsabilité de type intermédiaire entre hébergeur et média.

Ceci garantit aux plateformes une « immunité » en matière de responsabilité à partir du moment où elles prennent des mesures de modération automatique basées sur leurs propres algorithmes quand bien même ces mesures viseraient à retirer des contenus non illicites mais qui conviendraient à leur propre image (nudité, sujets jugés politiquement problématiques, censure locale etc..) C’était une des demandes des plateformes qui craignaient que ce genre de modération ne leur donne une responsabilité similaire à celle des médias (comme Trump a tenté de l’imposer sans succès aux Etats Unis), ce que nous souhaitions.

Le texte prévoit certes un cadre général pour les définitions des contenus illicites y compris les discours haineux, les contenus terroristes, les contenus discriminatoires illicites, les contenus pédopornographiques, le partage illégal d’images privées sans consentement, le harcèlement en ligne, la vente de produits contrefaits et l’utilisation non autorisée de matériel protégé par le droit d’auteur.

Cependant les fournisseurs d’accès intermédiaires continueraient à n’avoir aucune obligation de surveiller les informations qu’ils transmettent ou stockent ou de rechercher activement des faits ou des circonstances indiquant une activité illégale.

Le dispositif prévoit de demander aux usagers le droit de retrait d’un contenu illicite qui aurait été téléchargé et par ailleurs celui de pouvoir demander des explications en cas de retrait du contenu.

- Mais pour être considérée comme recevable, la demande de l’usager devra comporter des précisions telles que l’URL ou les URL exactes et des informations permettant l’identification du contenu illégal dont il s’agit. (C’était une demande récurrente de Google. En effet ainsi les plateformes échappent à

- L’obligation d’éliminer toutes les autres copies du même contenu qui se trouveraient dans un emplacement différent.)

- Il est précisé (art 20) que les plateformes ne suspendront la fourniture de leurs services qu’aux usagers qui fourniront fréquemment un contenu « manifestement illégal » (cette définition déjà proposée par la Commission dans ses lignes directives sur l’article 17 de la Directive copyright a suscité de nombreuses critiques au vu des difficultés d’interprétation qu’elle engendre

DMA

- La Commission propose des règles harmonisées au niveau européen pour les services de plateformes essentiels fournis ou offerts par les plateformes « systémiques » aux utilisateurs professionnels et aux utilisateurs finaux établis au sein de l’UE.

Si le texte était adopté dans sa forme actuelle par le Conseil et au final par le Parlement européen, l’UE mettrait en place le cadre règlementaire le plus strict au monde pour les pratiques concurrentielles des plateformes structurantes.La Commission a considéré que certaines plateformes numériques devraient être soumises à une règlementation « ex ante » (préalablement) car elles dominent l’économie numérique en assurant l’intermédiation d’une grande partie de l’accès entre les consommateurs et les entreprises, que ce soit pour les informations, les services ou les biens. Jusqu’à présent le droit européen de la concurrence n’est pas structuré pour permettre de traiter certaines questions soulevées par l’économie numérique, en raison du temps qu’il faut et des difficultés rencontrées pour parvenir à faire appliquer des mesures coercitives efficaces.

Contrairement au DSA qui s’applique à toutes les plateformes, le DMA n’est pas destiné à s’appliquer de manière horizontale à l’ensemble du secteur numérique, mais uniquement aux plateformes « structurantes », c’est-à-dire les géants du numérique : - Les services d’intermédiation en ligne (les marchés, les magasins)

- Les moteurs de recherche en ligne (Google)

- Les services de réseautage social en ligne (Facebook)

- Les services de plateforme de partage vidéos (YouTube)

- Les services de communication électronique interpersonnelle indépendant du numéro (site Web d’une entreprise)

- Les services de messagerie (WhatsApp)

- Les services en nuage

Ces plateformes doivent répondre à 3 critères :

- Si l’entreprise a réalisé un chiffre d’affaires annuel dans l’EEE de 6,5 milliards d’euros ou plus au cours des trois derniers exercices.

Ou si sa capitalisation boursière moyenne ou encore sa juste valeur marchande équivalente s’est élevée à au moins 65 milliards d’euros à l’issue du dernier exercice, et si elle fournit un service de plateforme structurante dans au moins trois Etats membres.

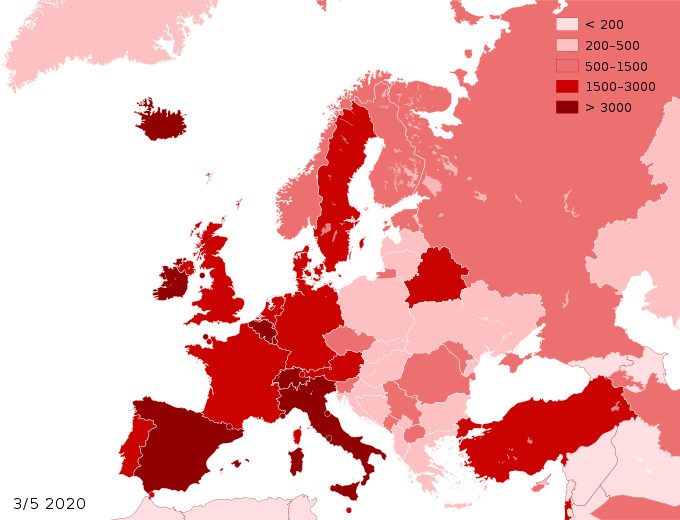

En fait, il s’agit des plateformes qui ont une taille telle qu’elles ont une incidence sur le marché intérieur - Si Elle a le contrôle d’une passerelle importante pour les utilisateurs professionnels vers les consommateurs finaux. Notamment si elle exploite un service de plateforme structurante avec plus de 45 millions d’utilisateurs finaux actifs mensuels dans l’UE (environ 10% de la population de l’Union) et plus de 10 000 utilisateurs professionnels actifs annuels dans l’Union au cours du dernier exercice financie

- Si Elle a une position bien établie et durable, ce qui serait acté si la plateforme remplit les deux critères ci-dessus.

Ces conditions sont considérées remplies à la suite d’un test quantitatif et qualitatif effectué par la Commission européenne.

Des études de marché pourraient être utilisées pour déterminer si d’autres services ou pratiques du secteur numérique devraient entrer dans le champ d’application du règlement (calendrier de 12 mois non contraignant) : ceci afin concevoir des mesures correctives supplémentaires pour les plateformes « structurantes » qui enfreignent systématiquement leurs obligations au titre du DMA (calendrier de 24 mois) Pour permettre la mise en œuvre de ces mesures, la Commission serait dotée de pouvoirs d’exécution sensiblement renforcés, notamment la capacité d’infliger des amendes pouvant aller jusqu’à 10%du CA total, de mener des inspections sur place ou des enquêtes sur le marché, d’imposer des mesures provisoires. Les contrevenants systématiques pourraient faire l’objet de mesures correctives comportementales et structurelles. Ce qui signifie que la Commission aurait le pouvoir de démanteler les grands opérateurs de plateformes dans certaines circonstances.

Le texte comporte aussi un grand nombre d’obligations auxquelles les plateformes devraient se conformer : - S’abstenir de combiner les données personnelles des services de base de la. plateforme avec les données personnelles d’autres services.

- S’abstenir de restreindre la liberté des utilisateurs professionnels de fixer librement leurs prix sur d’autres plateformes.

- S’abstenir de restreindre la liberté des utilisateurs professionnels de leur droit de porter plainte auprès des autorités publiques.

- S’abstenir d’exiger des utilisateurs professionnels qu’ils utilisent, offrent ou. interagissent avec un service d’identification du contrôleur d’accès.

- S’abstenir de subordonner l’accès à tout service de base de la plateforme à l’enregistrement ou l’abonnement d’utilisateurs à tout autre service de base de la plateforme.

Ces deux règlements (DSA ET DMA) applicables dès qu’ils seront définitivement adoptés ne seront sans doute pas opérationnels avant deux ans. Cependant ils sont un véritable élan. Lorsqu’ils seront en application, ils auront des répercutions mondiales. Le Japon a déjà annoncé le 16 décembre qu’il examinerait de près les nouvelles propositions européennes.

De ces deux textes c’est certainement le DMA le plus contraignant et celui qui pourrait bien être le plus grand bouleversement du secteur numérique de ces dernières années.

![[DSA, AI Act] Régulation, et si l’Europe avait raison ? Podcast les Eclaireurs du Numérique avec Jean-Marie Cavada](https://idfrights.org/wp-content/uploads/2023/12/8c234391-01e8-40d4-9608-4ea6c80d4f11-440x264.jpg)