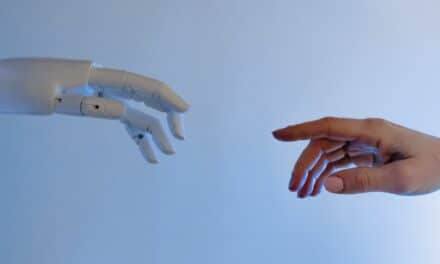

L’intelligence artificielle (IA) n’est plus une science réservée aux informaticiens. Le temps est venu, pour les juristes d’aujourd’hui, de s’en emparer pour construire la législation de demain. En effet, la croissance rapide de la technologie, notamment du fait de l’augmentation des capacités de calcul et de stockage, des progrès en algorithmie ou encore de l’émergence des données massives en lien avec le développement de l’environnement numérique,

a fait de l’IA un sujet juridique majeur depuis quelques années. Après diverses réflexions sous forme de résolutions, communications, rapports, livre blanc…, l’Union européenne s’engage dans la voie législative, avec une proposition de règlement, dite « Artificial Intelligence Act » (AI Act), présentée le 21 avril 2021.

Quelle approche de l’IA ?

L’enjeu est stratégique, les avantages espérés colossaux. L’Europe compte bien ici imposer sa vision et son rythme. L’objectif est en effet de s’inscrire dans un processus de compétitivité internationale économique et réglementaire : les acteurs dominants, américains et asiatiques, ont déjà investi le marché de l’IA et se désintéresser du sujet aboutira à subir leur loi. L’Europe a donc décidé de mener le jeu, en proposant une réglementation horizontale.

Si la technologie est promesse de progrès, elle est aussi source de dangers, pour les droits fondamentaux et la sécurité des personnes notamment. La question est simple et elle est principalement politique : quelle vision pour l’IA intégrée à notre société ? Quelle place pour l’humain face à cette innovation ? L’Union européenne a dessiné sa doctrine, au fil de ses interventions, conjuguant innovation et protection, investissement et confiance, progrès et contrôle. D’évidence, le point d’équilibre est subtil. Comment permettre le développement d’un écosystème d’excellence en matière d’IA européenne, tout en préservant une vision « human-centric » ? C’est tout l’objet de la proposition de règlement établissant des règles harmonisées en matière d’intelligence artificielle (COM(2021) 206 final), qui cherche à concilier tout à la fois la protection des individus, la sécurité juridique et l’innovation.

La proposition de règlement s’intègre dans un paquet, qui comprend également une Communication favorisant une approche européenne de l’intelligence artificielle (COM(2021) 205 final), un nouveau plan de coordination (révision du plan de 2018), ainsi qu’une proposition de règlement réformant la directive sur les machines (COM(2021) 202 final).

Plusieurs options normatives étaient avancées, d’une régulation souple, fondée sur la volonté des acteurs, à un encadrement législatif strict et obligatoire, pour tous les systèmes d’IA, en passant par une approche sectorielle. La voie choisie est, comme souvent, médiane (« option 3+ ») : un instrument législatif proposant une approche normative horizontale fondée sur le risque généré par la technologie en cause, couplé au cadre souple des codes de conduite volontaires pour les systèmes présentant les risques les plus faibles pour les droits fondamentaux.

Ainsi, il ne s’agit pas dans cette proposition de règlement de réguler la technologie en elle-même, mais plutôt la manière dont elle est utilisée. Pour ce faire, la Commission invente une pyramide des risques fondée sur les usages de l’IA et y associe un encadrement adapté, proportionnel au risque.

Quelle définition de l’IA ?

L’AI Act s’attache d’abord à trancher des qualifications. Ainsi, le texte a vocation à s’appliquer à certains « systèmes d’intelligence artificielle », expression qui a été préférée à celle d’intelligence artificielle, laquelle renvoie plus à une discipline, une science, qu’à des usages. La technologie est non seulement plurielle, mais elle a vocation à s’appliquer à des domaines et pour des usages très variés.

Le système visé est défini, à l’article 3, § 1, comme « un logiciel développé à l’aide d’une ou plusieurs des techniques et approches énumérées à l’annexe I de la proposition et capable, pour un ensemble donné d’objectifs définis par l’homme, de générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels ils interagissent ». Malgré une volonté déclarée par la Commission de neutralité technologique, l’annexe I énumère trois catégories de techniques algorithmiques, en substance les systèmes auto-apprenants (le machine learning), les systèmes logiques et les systèmes statistiques.

La méthode retenue est particulièrement compréhensive, incluant l’approche symbolique et l’approche connexionniste. Il est heureux que la Commission n’ait pas limité sa compétence à l’apprentissage automatique, technique très médiatisée et qui a beaucoup progressé sous l’influence notamment des données massives (big data), mais qui reste une technique parmi d’autres. Il est encore heureux que toute référence à la corporéité ou au « robot » ait été abandonnée : le régime applicable ne saurait dépendre de l’existence ou non d’une enveloppe physique. D’aucuns regretteront cependant l’ouverture de la définition (qu’est-ce qui finalement échappe à l’IA ?), contribuant à la tendance de faire de l’IA un argument « marketing » mais non toujours effectif. Pour atténuer la critique, il faut rappeler que les approches considérées comme de l’IA ont varié au fil du temps, en considération des écoles historiques, sans doute aussi au gré des modes. Enfin, le système vise-t-il réellement le « logiciel » – impliquant alors d’appliquer le régime spécial du droit d’auteur qui lui est dédié – ou bien la fonctionnalité de ce logiciel – mais qui échappe alors à la protection spéciale ?

Cela étant, tous les systèmes d’IA ne sont pas concernés par l’encadrement envisagé : outre la variabilité des obligations, en lien avec le niveau de risque, les systèmes d’IA développés ou utilisés exclusivement à des fins militaires sont exclus (art. 2, § 3). En outre, les usages visés sont les usages professionnels. En effet, l’utilisateur d’un système d’IA à des fins personnelles et non-professionnelles est exclu du champ d’application du règlement (art. 3, § 4).

Quelles règles pour l’IA ?

Le texte propose un régime graduel : les usages considérés comme « inacceptables » sont tout simplement interdits (art. 5), même si des exceptions existent ; ceux jugés « à haut risque » sont soumis à un régime de régulation précis (art. 6 à 51) ; ceux évalués à faible risque sont guidés par un principe de transparence (art. 52) ; enfin, les systèmes qui présentent un risque minime ne sont pas régulés par le texte.

Le sommet de la pyramide réserve les interdits, pour les systèmes impliquant des risques considérés comme inacceptables au regard des valeurs européennes, notamment des droits fondamentaux. Quatre usages de l’IA sont ainsi exclus à l’article 5, § 1 : les systèmes d’IA qui influencent de manière subliminale les comportements, ceux qui exploitent la vulnérabilité d’une personne, les systèmes de notation sociale d’origine publique et les systèmes d’identification biométrique à distance en temps réel dans des espaces accessibles au public (reconnaissance faciale). Cette dernière interdiction est néanmoins assortie d’exceptions très larges (la recherche ciblée de victimes de crime, y compris les enfants disparus ; la prévention d’une menace spécifique, substantielle et imminente pour la vie ou la sécurité des personnes, dont l’attaque terroriste ; la détection, localisation, identification ou poursuite d’un auteur ou suspect d’une infraction pénale passible d’une peine d’emprisonnement d’au moins trois ans). Aussi, malgré la mise en place de garde-fous – dans la mesure où l’utilisation de pareils systèmes doit s’avérer nécessaire, proportionnée, être autorisée par une autorité administrative ou judiciaire et préalablement encadrée par une loi détaillant l’usage –, les dérogations conduisent à vider le principe d’une partie de sa substance.

L’encadrement le plus détaillé mobilise les utilisations d’un système d’IA considéré comme à haut risque. La classification proposée est double (art. 6). Dans une première hypothèse, la qualification dépend de conditions : elle concerne tout système (autonome ou embarqué dans un produit) couvert par une des législations harmonisées de l’UE listées en annexe II et qui est soumis à une évaluation de conformité en vertu de ces mêmes textes. Le champ est particulièrement large puisque sont visées les législations sur les machines, les jouets, les navires de plaisance, les ascenseurs, les équipements et systèmes de protection destinés à être utilisés en atmosphères explosibles, les installations à câbles, les dispositifs médicaux, la sûreté de l’aviation civile, la réception et la surveillance du marché des véhicules à deux ou trois roues et des quadricycles, ainsi que des véhicules agricoles et forestiers, les équipements marins, l’interopérabilité du système ferroviaire, etc. Dans une seconde hypothèse, la qualification est automatique : sont ainsi considérés comme systèmes à haut risque les systèmes d’IA visés à l’annexe III, lequel identifie des secteurs, comme les infrastructures critiques, l’éducation, les services publics ou privés essentiels, la justice… L’AI Act anticipe une extension des usages, à l’article 7, permettant à la Commission de revoir la liste de l’annexe III dès lors que les systèmes sont susceptibles de porter atteinte aux droits fondamentaux dans les domaines visés.

Dans ce champ des IA à haut risque, la proposition s’inscrit, dans le sillon du RGPD notamment, dans un modèle de régulation, imposant dès l’amont une mise en conformité (déclarée) du système, ou compliance (art. 8), avec la préconstitution de preuves de cette conformité, pour faciliter les contrôles. Le régime implique notamment la mise en œuvre d’une procédure continue de gestion des risques (art. 9), une politique contraignante de gouvernance des données utilisées pour l’entraînement, la validation ou encore les tests, afin de s’assurer de leur qualité et éviter les biais (art. 10), l’établissement d’une documentation technique dont le contenu est précisé l’annexe IV (art. 11), la tenue de fichiers de journalisation (art. 12), une obligation de transparence et d’information au bénéfice des utilisateurs (art. 13), une surveillance humaine du système visant à prévenir ou minimiser les risques (art. 14), des obligations d’exactitude, de robustesse et de cybersécurité (art. 15). Des procédures d’évaluation préalable et de contrôle de la conformité sont décrites. De ce cadre découlent de nombreuses obligations mises à la charge du redevable, le fournisseur (art. 16 s.), que l’article 3 définit comme « la personne physique ou morale, l’autorité publique, l’agence ou autre organisme qui développe un système d’IA ou qui fait développer un système d’IA en vue de le mettre sur le marché ou de le mettre en service sous son propre nom ou sa propre marque, que ce soit à titre onéreux ou gratuit ». Cette qualité, à laquelle est donc associée la responsabilité, peut être étendue à d’autres personnes qui agissent sur le système (art. 28). Le régime proposé est touffu et il n’est pas question d’en relayer l’intégralité, mais on signalera encore la création d’un Comité européen (European Artificial Intelligence Board, art. 56 s.), soutenant le modèle de régulation affiché, et la mise en place d’autorités nationales au sein des Etats membres pour vérifier l’application et l’implémentation du règlement (art. 59), sur le modèle du RGPD (et du futur DSA). Enfin, la proposition se veut pragmatique, consacrant un système de bac à sable (sandbox), pour permettre aux petites et moyennes entreprises d’entrer sur le marché sans que la mise en conformité ne constitue une entrave. Sur ce point, la dérogation permise, dans l’intérêt public, au droit des données personnelles devra sans doute être davantage encadrée.

Par ailleurs, pour les systèmes à faible risque, une obligation de transparence vis-à-vis des utilisateurs (art. 52) est imposée. Trois hypothèses sont envisagées, sans que l’on sache si d’autres usages pourraient ou non entrer dans cette catégorie : lorsque les systèmes d’IA sont destinés à interagir avec une personne (chatbots), lorsqu’ils ont pour finalité la reconnaissance d’émotion ou la catégorisation biométrique et lorsqu’ils génèrent ou manipulent des contenus (deep fakes). L’utilisateur doit ici connaître le lien avec le système d’IA, l’objectif étant de limiter les manipulations possibles. L’obligation n’a cependant pas vocation à s’appliquer aux systèmes autorisés par la loi et destinés à détecter, prévenir, enquêter et poursuivre les infractions pénales.

Enfin, la base de la pyramide est constituée des systèmes d’IA présentant un risque minime. La catégorie n’existe que par défaut et l’absence de définition suscitera sans doute des discussions, car les usages ne sont alors pas régulés par l’AI Act. Ce qui, évidemment, ne signifie pas qu’ils ne supportent pas le poids d’autres législations, portant notamment sur la sécurité des produits ou les données à caractère personnel.

D’évidence, la qualification sera un enjeu fondamental tant les contraintes divergent. La différence entre le cadre particulièrement contraignant des systèmes à haut risque et celui, très allégé, des systèmes à risque limité ou minimal est telle que le rattachement à une catégorie deviendra sans doute une source de contentieux.

En conclusion, on regrettera quelques manques (quid des recours individuels contre des décisions algorithmiques, de l’impact écologique… ?), sans doute également quelques excès, en particulier sur le champ des exceptions à l’interdiction posée en matière de reconnaissance faciale (excès d’ailleurs dénoncé par le CEPD) ou encore des frontières encore floues. Mais le processus ne fait que commencer et on peut imaginer que chacun fera valoir ses arguments. A ce stade, il faut louer la volonté d’une législation contraignante (assortie de fortes sanctions financières en cas de manquement – 2, 4 ou 6 % du chiffre d’affaires annuel), à l’échelle européenne, voie préférée – et c’est heureux – à un encadrement souple et volontaire, fondé sur l’éthique.

![[DSA, AI Act] Régulation, et si l’Europe avait raison ? Podcast les Eclaireurs du Numérique avec Jean-Marie Cavada](https://idfrights.org/wp-content/uploads/2023/12/8c234391-01e8-40d4-9608-4ea6c80d4f11-440x264.jpg)